Sam Altman podgrzewa atmosferę. Premiera nowego modelu ChatGPT już za chwilę?

Szef firmy OpenAI znów jest na ustach wszystkich. Z pozoru niewinny post na platformie X sprawił, że wielbiciele nowoczesnych technologii zaczęli zastanawiać się, czy ma jego treść ma cokolwiek wspólnego z ChatGPT.

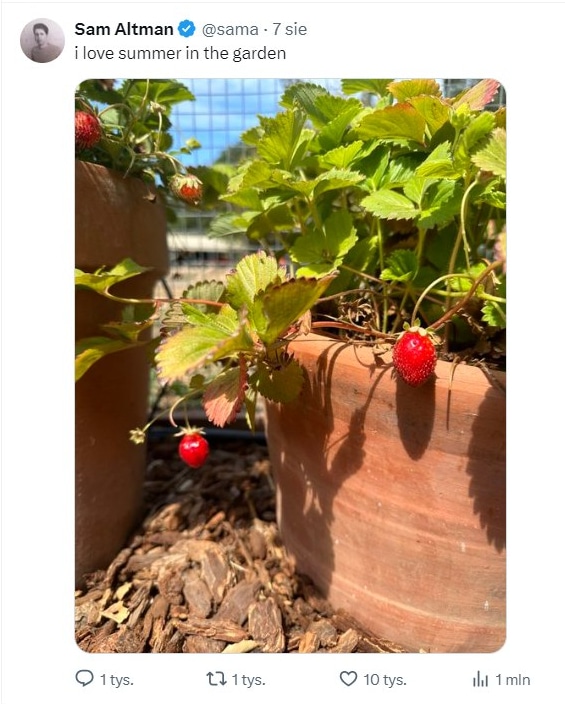

Chodzi o post Sama Altmana na temat należącego do biznesmena truskawkowego ogrodu. Został on opublikowany na platformie X w minioną środę.

Kolejny ChatGPT czai się za rogiem?

To pozornie zwykła fotka może jednak zawierać pewien przekaz. Otóż dociekliwi internauci zauważyli, że zdjęcie zawiera trzy dojrzałe truskawki, z których jedna jeszcze nie zmieniła koloru na czerwony, co według użytkowników X może być wskazówką na temat powszechnie oczekiwanego modelu ChatGPT 4.5.

„4 truskawki… i jeszcze jedna na wpół rozwinięta… to musi być znak GPT 4.5!” – napisał użytkownik o pseudonimie Mirr. „To się dzieje” – wtórował mu Dogan Ural. Ale inni użytkownicy X nie byli tak rozbawieni postem Altmana. „Dlaczego nie możesz mówić wprost, człowieku” – irytował się współzałożyciel firmy Altera, Nico Christie.

Przypomnijmy, że 14 maja br. OpenAI udostępniło swój najnowszy model sztucznej inteligencji, GPT-4o, który potrafi wykonywać różnorodne zadania związane z przetwarzaniem języka naturalnego. Do jego najważniejszych umiejętności można zaliczyć generowanie tekstu, odpowiadanie na pytania, tłumaczenie języków, streszczanie tekstów, tworzenie kodu, analizować emocjonalny ton tekstu, prowadzić rozmowy z użytkownikiem, generować pomysły, prowadzić symulację postaci, a także edukować i pomagać w nauce.

Sam Altman nie potwierdził ani nie zaprzeczył żadnym spekulacjom na temat ze swojego postu w mediach społecznościowych, poza potwierdzeniem, że zdjęcie przedstawia jego „prawdziwy ogród”. Również firma OpenAI nie udzieliła żadnego komentarza na temat postu. Przedsiębiorstwo nie ogłosiło też żadnych zmian w ChatGPT 4.5, ale w sieci pojawiają się kolejne spekulacje, że nowa odsłona interfejsu użytkownika oparty na modelu językowym może mieć poprawioną szybkość, dokładność i zdolność do obsługi bardziej złożonych zadań.

Kontrowersji nie brakuje

Warto w tym miejscu przypomnieć, że pod koniec lipca OpenAI rozpoczęła wdrażanie niesamowicie podobnego do ludzkiego interfejsu głosowego dla ChatGPT. W opublikowanej w dniu wczorajszym analizie bezpieczeństwa firma przyznała, że ten antropomorficzny głos może zwabić niektórych użytkowników do emocjonalnego przywiązania się do chatbota.

Lucie-Aimée Kaffee, badaczka polityki stosowanej w Hugging Face, firmie, która hostuje narzędzia AI, zauważa, że karta systemowa OpenAI dla GPT-4o nie zawiera szczegółowych informacji na temat danych treningowych modelu ani tego, kto jest właścicielem tych danych. – Należy zająć się kwestią zgody na tworzenie tak dużego zbioru danych obejmującego wiele modalności, w tym tekst, obraz i mowę – mówi Kaffee. Inni zauważają, że ryzyko może ulec zmianie w miarę wykorzystywania narzędzi w środowisku naturalnym. – Ich wewnętrzny przegląd powinien być tylko pierwszym elementem zapewnienia bezpieczeństwa AI – przyznał Neil Thompson, profesor na MIT, który bada oceny ryzyka AI. – Wiele zagrożeń ujawnia się dopiero wtedy, gdy sztuczna inteligencja jest wykorzystywana w prawdziwym świecie. Ważne jest, aby te inne zagrożenia były katalogowane i oceniane w miarę pojawiania się nowych modeli – dodał.