OpenAI, Altman: wirtualni pracownicy już w tym roku! Vitalik: a może by tak wziąć nieco na wstrzymanie?

Sam Altman, pomimo prawnych bojów z Elonem Muskiem i rosnących obaw obserwatorów dotyczących tempa i kierunków rozwoju AI, nie traci optymizmu. Prezes OpenAI przyszłość swą (i swych produktów) widzi ogromną. Co więcej, widzi ją także jako perspektywę bardzo bliską czasowo. O co chodzi konkretnie?

Otóż Altman wierzy, że już w tym roku uda się opracować narzędzia AI, których definicja i funkcjonalność wykroczą daleko poza zwykłe i nieomal już powszechne modele LLM (large language model). Miały to by być przykłady tzw. agentów AI. Nie chodzi tutaj o żadne powiązania ze służbami specjalnymi czy agencjami, lecz o wirtualne narzędzie wyposażone we własną sprawczość.

Tak bowiem w tym kontekście należy przetłumaczyć termin „agency„. Modele takie byłyby w zamierzeniu pełnosprawnym, autonomicznym robotem wirtualnym. Miałyby być zdolne do samodzielnej analizy sytuacji, wyznaczania priorytetów i samodzielnej realizacji wyznaczanych im zadań. Konstrukty takie, bardziej niż nieco kontrowersyjne, określa się też jako modele AGI (artificial general intelligence).

„We are now confident we know how to build AGI as we have traditionally understood it. We believe that, in 2025, we may see the first AI agents “join the workforce” and materially change the output of companies. We continue to believe that iteratively putting great tools in the hands of people leads to great, broadly-distributed outcomes.”

~ Sam Altman,

prezes OpenAI

Wprowadzenie na rynek takich rozwiązań, a zwłaszcza rozpowszechnienie się w biurach czy fabrykach „kolegów AI” mogłoby być przy tym niemałym szokiem społecznym. Nie tylko w sensie mentalnym, bowiem konsekwencje takiej rewolucji na rynku pracy byłyby aż nadto odczuwalne dla tysięcy pracowników, którym nagle zajrzała w oczy konieczność przekwalifikowania się.

I choć postępu technicznego nie sposób zatrzymać (nawet gdyby miało to sens), to towarzyszące temu wstrząsy miewają dalekosiężne skutki. Tym bardziej, że to niejedyne problemy, jakie przy tej okazji trzeba wziąć pod uwagę.

Sam Altman i jego (coraz większe) grono „fanów”

Komu miałoby się udać opracowanie AGI? Tego Sam Altman nie sprecyzował – ale logiczne, że chodzi mu o jego firmę. Tyle, że OpenAI nie słynie z ostrożności w działaniu, a raczej wprost przeciwnie. Przynosi to zresztą rynkowe efekty, zaś jej ChatGPT zdobył dzięki temu trudną do podważenia pozycję na rynku. Tysiące (miliony?) ludzi na świecie korzysta z tego bota lub jego pochodnych, firma uchodzi zaś za lidera technologicznego wyścigu.

Tyle, że polityka rozwoju bez oglądania się na potencjalne problemy budziła i budzi coraz większe zaniepokojenie i krytykę. Nawet w samej OpenAI, w zarządzie której ponad rok temu wybuchł rokosz przeciwko szefowi. I choć Sam Altman (z niemałą pomocą Microsoftu) utrzymał się u władzy, „buntowników” wysyłając na banicję do ich własnych startupów, to problemu to nie rozwiązało.

Opracowanie modeli AGI i „agentów AI” to bowiem jedno – zupełnie innym zagadnieniem jest natomiast zapewnienie (ale tak na pewno…) by podobne wynalazki nie wymknęły się spod kontroli. Tym bardziej, że w ich rozwoju z tylnego siedzenia maczają swe palce tacy aktorzy jak, przykładowo, amerykańskie agencje wywiadowcze. Ergo, podmioty, które raczej nie przynoszą pewności, że AI nie zostanie źle wykorzystana.

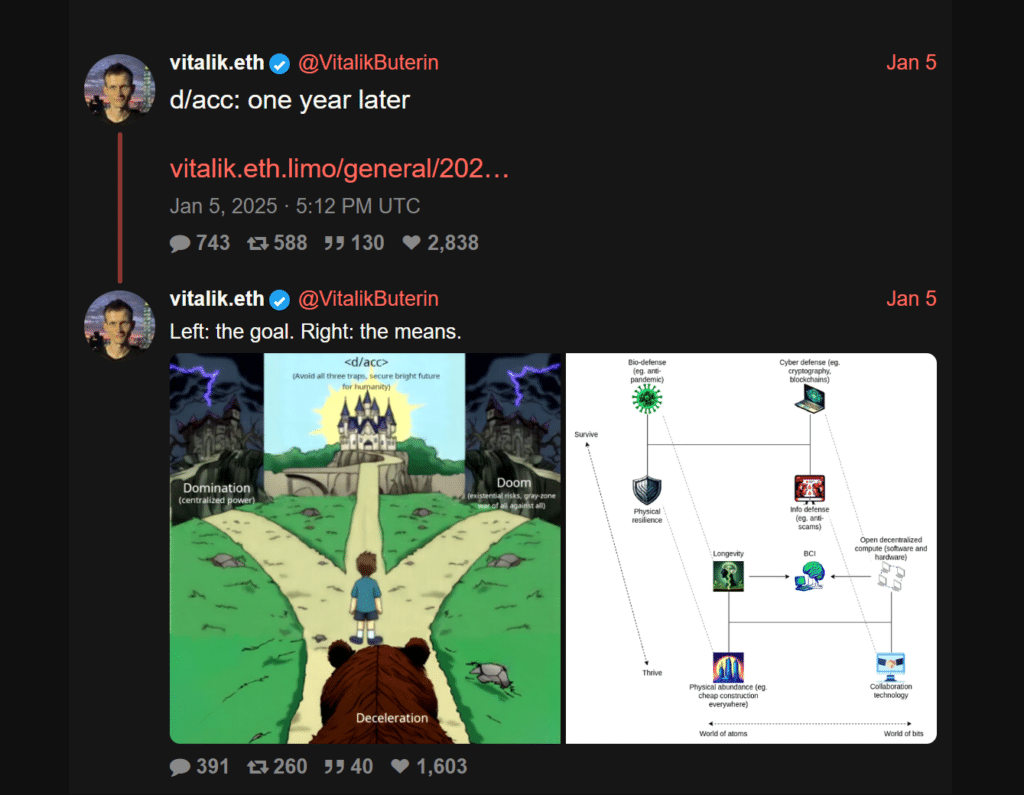

Nie dziwi zatem, że OpenAI i osobiście Sam Altman znaleźli się w ogniu krytyki ze strony takich postaci jak Geoffrey Hinton, tegoroczny noblista z fizyki, zwany „ojcem chrzestnym AI”. Najnowszym z zaniepokojonych głosów okazał się Vitalik Buterin. W niedzielę, raptem dzień przed pełnym wizjonerskich obrazów wpisem prezesa OpenAI, współtwórca Ethereum wezwał do radykalnego podcięcia jego wizji.

A może by tak wyjechać w elektroniczne Bieszczady…?

Vitalik proponuje bowiem ni mniej, ni więcej, by wstrzymać niekontrolowany rozwój AI. Jak miałoby to wyglądać? Postuluje on, aby ograniczyć globalnie dostępną moc obliczeniową, która byłaby dostępna do wykorzystania nad rozwojem modeli AI. O drobne 99%, plus minus. I chciałby, by taką pauzę ogłosić co najmniej na rok lub dwa.

Jak argumentuje, taka przerwa zapewniłaby ludzkości oddech i możliwość przygotowania się na ewentualność, w której – gdy za kilka lat w pełni autonomiczna AGI faktycznie stanie się rzeczywistością – obawy o jej niezależność od człowieka faktycznie się potwierdzą.

Można się domyślać, jak Sam Altman zareagowałby na podobną sugestię. Po części zresztą to uczynił – podobne obawy po prostu w swym wpisie zbywając. W końcu „jesteśmy tu dla wspaniałej przyszłości!„