Bitcoin spadnie do zera? Google ma nowy komputer kwantowy: „w 5 minut liczy to co innym zajmuje 10 kwadrylionów lat”

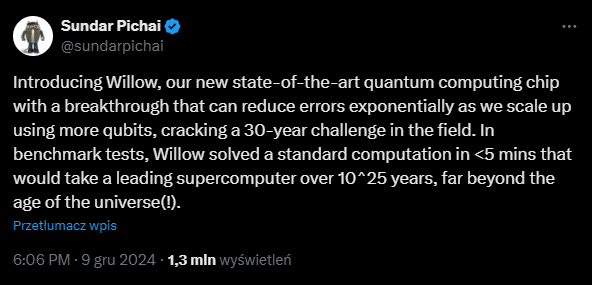

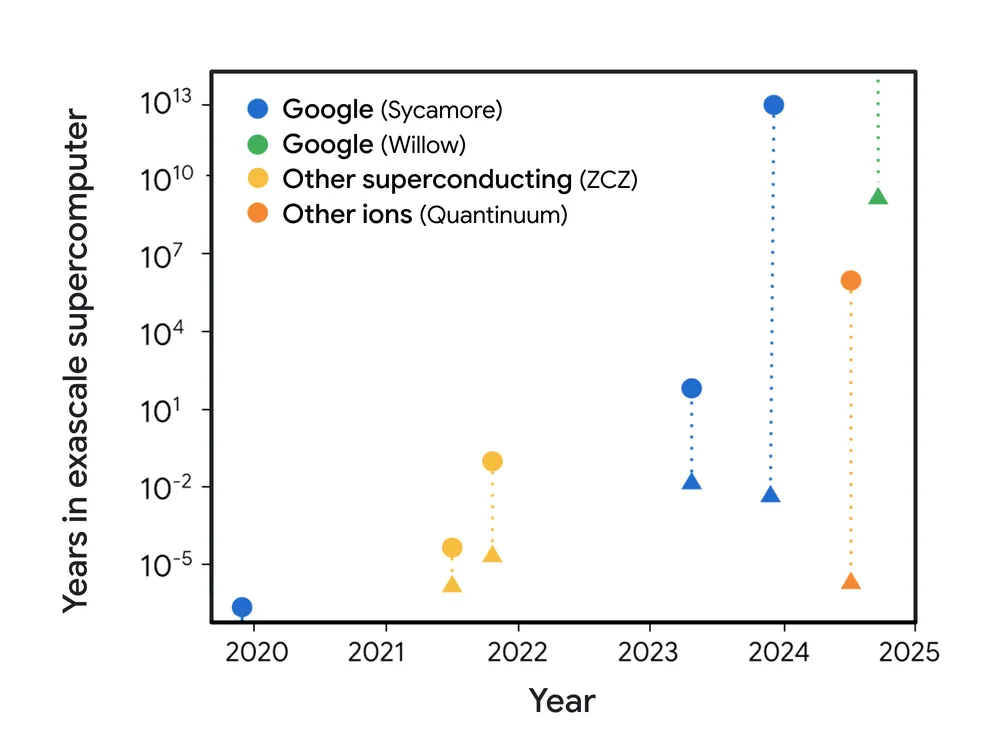

Zespół Google Quantum AI zaprezentował dzisiaj swój najnowszy, przełomowy układ kwantowy o nazwie Willow. Jak podkreśla Sundar Pichai, dyrektor generalny spółki Alphabet i Google, a także pionierzy zespołu Google Quantum AI, Willow nie tylko redukuje błędy kwantowe w sposób wykładniczy, ale też osiąga wydajność nieporównywalną z najszybszymi obecnymi superkomputerami. W testach porównawczych nowy chip zrealizował obliczenia, które standardowym, klasycznym maszynom zajęłyby „czas dłuższy niż wynosi znany wiek Wszechświata”. Czy zatem kryptowaluty i Bitcoin (BTC), które opierają się na mechanizmach, które (teoretycznie) można złamać przy użyciu dostatecznie potężnej mocy obliczeniowej, jest zagrożony? Postaramy się odpowiedzieć na to pytanie na samym końcu.

Kwantowe łamanie barier – problem 30-letni

Nowy produkt zaprezentowano jako długo wyczekiwany krok milowy na drodze do budowy wielkoskalowego komputera kwantowego zdolnego do rzeczywistych, komercyjnych zastosowań. Jeśli wierzyć materiałom PR-owym Google’a, Willow może stać się punktem zwrotnym w ponad 30-letnich badaniach nad korekcją błędów kwantowych i praktyczną użytecznością algorytmów kwantowych.

Od początku lat 90. naukowcy zmagali się z jedną z największych przeszkód na drodze do zbudowania praktycznego komputera kwantowego: błędami. Qubity, podstawowe jednostki informacji kwantowej, są niezwykle wrażliwe na zakłócenia środowiskowe. W rezultacie w miarę dodawania kolejnych qubitów do systemu, jego delikatna „kwantowość” łatwo zanikała, a wynik obliczeń stawał się nieprzydatny.

Willow, najnowszy układ wyprodukowany w specjalistycznym zakładzie Google Quantum AI w Santa Barbara, zdołał podobno dokonać tego, co uchodziło za jedną z największych barier: wykładniczo zmniejszył liczbę błędów wraz ze wzrostem liczby qubitów. Badacze przetestowali działanie układu na coraz większych siatkach qubitów – od macierzy 3×3, poprzez 5×5, aż po 7×7 – każdorazowo zespół uzyskiwał sukcesywne zmniejszenie częstości błędów o połowę. Ten fenomen to tzw. „przekroczenie progu” (below threshold) w dziedzinie korekcji błędów, czyli punkt, w którym dodawanie kolejnych qubitów zamiast pogarszać, zaczyna systematycznie poprawiać działanie całego układu kwantowego.

„To fundament funkcjonalnej korekcji błędów kwantowych, na który czekaliśmy od czasu, gdy Peter Shor zaproponował tę koncepcję w 1995 roku. Oznacza to, że wreszcie możemy budować większe, stabilniejsze i w pełni kwantowe systemy, nie tracąc informacji przy powiększaniu skali” – podkreśla Hartmut Neven, założyciel i szef Google Quantum AI.

Wynik poza zasięgiem klasycznych superkomputerów

Opracowując Willow, zespół Google Quantum AI wykorzystał tzw. random circuit sampling (RCS) – niezwykle trudny test, który jest dziś jednym ze standardowych sprawdzianów dla komputerów kwantowych. Pozornie losowe, niezwykle skomplikowane obliczenia miały wykazać, czy Willow jest w stanie przeprowadzić zadania niewykonalne dla klasycznych maszyn w „rozsądnym” czasie. Rezultat podobno przerósł oczekiwania: chip Willow zakończył obliczenia w ciągu kilku minut, podczas gdy jeden z najszybszych superkomputerów świata – Frontier – potrzebowałby do tego trudnych do objęcia rozumem 10^25 lat (dziesięć sektylionów lat, czyli 10 000 000 000 000 000 000 000 000 lat).

Dla porównania: wiek Wszechświata szacuje się na około 13,8 mld lat. Oznacza to, że w sensie praktycznym, żaden klasyczny komputer nie jest w stanie dogonić możliwości układu Willow w tego typu zadaniu. Ten olbrzymi skok wydajności – określany już jako „ponad-klasyczny” – sugeruje, że kwantowa moc obliczeniowa może rosnąć w tempie nieosiągalnym dla tradycyjnych architektur.

Infrastruktura i inżynieria kwantowa na najwyższym poziomie

Jak czytamy w komunikacie prasowym Google’a, Willow powstał w „supernowoczesnej fabryce w Santa Barbara, jednym z nielicznych na świecie ośrodków zbudowanych specjalnie z myślą o wytwarzaniu wielkoskalowych układów kwantowych”. Projekt takiego chipu wymaga inżynierii na poziomie systemowym. Liczy się nie tylko liczba qubitów, ale także ich jakość, stabilność oraz to, jak poszczególne elementy współdziałają. Każde zakłócenie – od drgań w infrastrukturze chłodzenia po niedoskonałości w procesach litograficznych – może wpłynąć na spójność kwantową układu.

Jak informuje zespół projektowy, czas relaksacji T1 (okres, w którym qubit zachowuje swój stan) w Willow przekroczył 100 mikrosekund. To aż pięciokrotny wzrost w stosunku do wcześniejszych generacji. W połączeniu z rozbudowaną korekcją błędów oznacza to zbliżenie się do praktycznej użyteczności algorytmów kwantowych na skalę przemysłową.

Kolejny krok: użyteczne, komercyjnie wartościowe obliczenia kwantowe

Choć osiągnięcia Willow to wielki skok naprzód, naukowcy z Google Quantum AI nie zamierzają na tym poprzestać. Ich kolejnym wyzwaniem jest opracowanie praktycznych zadań, które wykraczają poza możliwości klasycznych komputerów, a przy tym mają realne, komercyjne znaczenie. Dotychczasowe eksperymenty udowodniły przewagę kwantową w zadaniach takich jak RCS, jednak te benchmarki nie przekładają się bezpośrednio na zastosowania w przemyśle, medycynie czy energetyce.

Celem jest opracowanie algorytmów kwantowych, które nie tylko wygrywają z klasycznymi maszynami w egzotycznych testach, ale będą w stanie skrócić czas odkrycia nowych leków, zoptymalizować procesy chemiczne, przyspieszyć poszukiwanie lepszych materiałów czy pomóc w modelowaniu zjawisk fizycznych związanych z fuzją jądrową. Co więcej, zdaniem Nevena i jego zespołu, kluczowym beneficjentem rozwoju kwantowych technologii może być również sztuczna inteligencja. Zaawansowane systemy AI, mając dostęp do mocy kwantowych obliczeń, mogłyby znacznie szybciej uczyć się, trenować modele i znajdować wzorce, które dla klasycznych komputerów pozostają niedostępne.

Czy Bitcoin jest zagrożony?

Czy zatem Bitcoin może zniknąć z rynku, a jego wartość spaść do zera, jeśli pojawi się technologia zdolna błyskawicznie złamać jego zabezpieczenia kryptograficzne?

W istocie Bitcoin – a dokładniej klucze prywatne i zasady działania sieci oparte na kryptografii asymetrycznej – może kiedyś znaleźć się w zasięgu takich maszyn. To jeszcze nie dziś i nie jutro, bo nawet przełomowy chip kwantowy dopiero przeciera szlaki, a sama branża nie ma jeszcze praktycznych narzędzi do efektywnego ataku na protokoły kryptowalutowe. Jednak to, co kiedyś wydawało się czysto teoretyczną obawą, staje się coraz bardziej realne. Jeżeli rozwój mocy obliczeniowej w reżimie kwantowym będzie przebiegał tak szybko, jak sugerują ostatnie wyniki, pytanie brzmi nie „czy”, ale raczej „kiedy” komputery kwantowe osiągną poziom umożliwiający kompromitację tradycyjnej kryptografii.

W tym świetle to, czy Bitcoin kiedykolwiek spadnie do zera, będzie zależeć m.in. od zdolności społeczności i programistów do wprowadzania kwantowo-odpornych rozwiązań.

Przypomnijmy: wprowadzanie ulepszeń do protokołu odbywa się na drodze tzw. Bitcoin Improvement Proposals (BIP), czyli formalnych propozycji zmian. Każdy, kto ma pomysł na usprawnienie sieci – od optymalizacji wydajności, poprzez zwiększenie skalowalności, aż po wprowadzenie mechanizmów odpornych na ataki kwantowe – może przedstawić swoją koncepcję do dyskusji. Następnie propozycja jest publicznie debatowana, analizowana i testowana. Jeśli zyska odpowiednio szerokie poparcie wśród górników, węzłów i użytkowników, staje się częścią kodu i w ten sposób wchodzi do protokołu.

Z drugiej strony powstaje pytanie, czy w obliczu postępu w technologii kwantowej, rynek sam z siebie, całkowicie spontanicznie nie zacznie sam odchodzić od starych standardów na rzecz nowych, odpornych na takie i podobne zagrożenia. W końcu ochrona wartości cyfrowych aktywów wymaga ciągłej ewolucji metod zabezpieczeń – a potencjalna moc kwantowych układów w stylu Willow jest jasnym sygnałem, że ewolucja ta musi w końcu zacząć nadążać za nowym światem.

Na pocieszenie: przypominamy, że deklaracje że Bitcoin skończy tragicznie nie są niczym nowym, a kryptowaluta w międzyczasie stale rosła: powstały nawet specjalne repozytoria, które zbierają w jedno miejsce wszystkie bardziej medialne deklaracje o „śmierci BTC”. Przykład znajdziecie chociażby tutaj: